robots.txtとXMLサイトマップ(sitemap.xml)は、検索エンジンのクロールを効率化し、新しいまたは更新されたコンテンツを早く検索結果に反映するのに役立ちます。

robots.txtは、クローラーに対して、どのページをクロールしてよいのか、または避けるべきかを指示するファイルです。一方、XMLサイトマップは、Webサイト上のすべてのページ情報を検索エンジンに効率よく提供するためのファイルです。

この記事では、月間1億PVのポータルサイトをゼロから作りあげた経験をもとに、robots.txtとXMLサイトマップの役割や関係性について詳しく解説します。

robots.txtとXMLサイトマップ(sitemap.xml)の関係性とは?

robots.txtとXMLサイトマップの関係性を一言で述べると、「robots.txtがXMLサイトマップの認識を手助けする」になります。

具体的には、robots.txtのテキスト内にXMLサイトマップの情報を記載することで、クローラーはXMLサイトマップの情報を把握しやすくなります。

robots.txtに記述することで、XMLサイトマップの情報をクローラーに伝える

クローラーは、サイト内をクロールする前に、まずはrobots.txtのファイルに書かれてある情報を把握しようとします。

そして、robots.txtの中にXMLサイトマップの情報が記載されている場合、クローラーはrobots.txt内のXMLサイトマップの情報を把握します。最終的には、XMLサイトマップ内に記載されているURLの情報をクロールしようとします。(※ただし、記載されている全てのURLをクロールするとは限りません)

robots.txtにXMLサイトマップを記述する方法

XMLサイトマップをrobots.txtに記述する方法は簡単で、Sitemap: [サイトマップのURL]の形で記述します。

具体的には、

Sitemap: https://example.com/sitemap.xml

といった形で絶対URLで記述します。

【注意点】robots.txtでDisallowしているURLをXMLサイトマップに含めない

「Disallow」は、クローラーに特定のURLをクロールしないよう指示する命令です。

Disallowでクロールを禁止しているURLをXMLサイトマップに含めると、それは矛盾した行為となり、SEOにマイナスな影響を与える可能性があります。

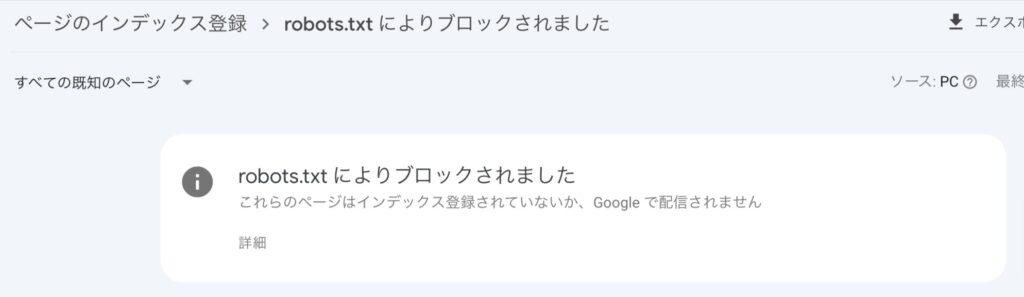

このようなURLは、Googleサーチコンソールの「ページ」>「ページがインデックスに登録されなかった理由」>「robots.txtによりブロックされました」で確認できます。

robots.txtとXMLサイトマップ(sitemap.xml)の確認方法

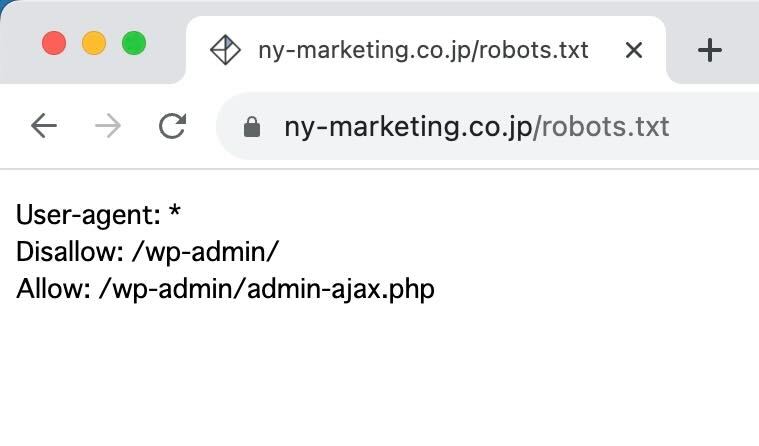

ここでは、robots.txtとXMLサイトマップ(sitemap.xml)の設定を確認する方法を解説します。弊社https://ny-marketing.co.jp/を例に見てみましょう。

robots.txtの確認方法

robots.txtはサイトURLの末尾に/robots.txtと入力することで確認できます。

User-agent: *は、すべての検索エンジンのクローラーに適用されるルールです。

上記の例では、Disallow: /wp-admin/は、/wp-admin/ディレクトリへのアクセスを禁止しています。一方、Allow: /wp-admin/admin-ajax.phpは、特定のファイルへのアクセスを許可しています。

robots.txt内でXMLサイトマップが指定されている場合もありますが、これは必須ではありません。指定されている場合、通常はSitemap: [サイトマップのURL]といった形で記述します。

XMLサイトマップ(sitemap.xml)の確認方法

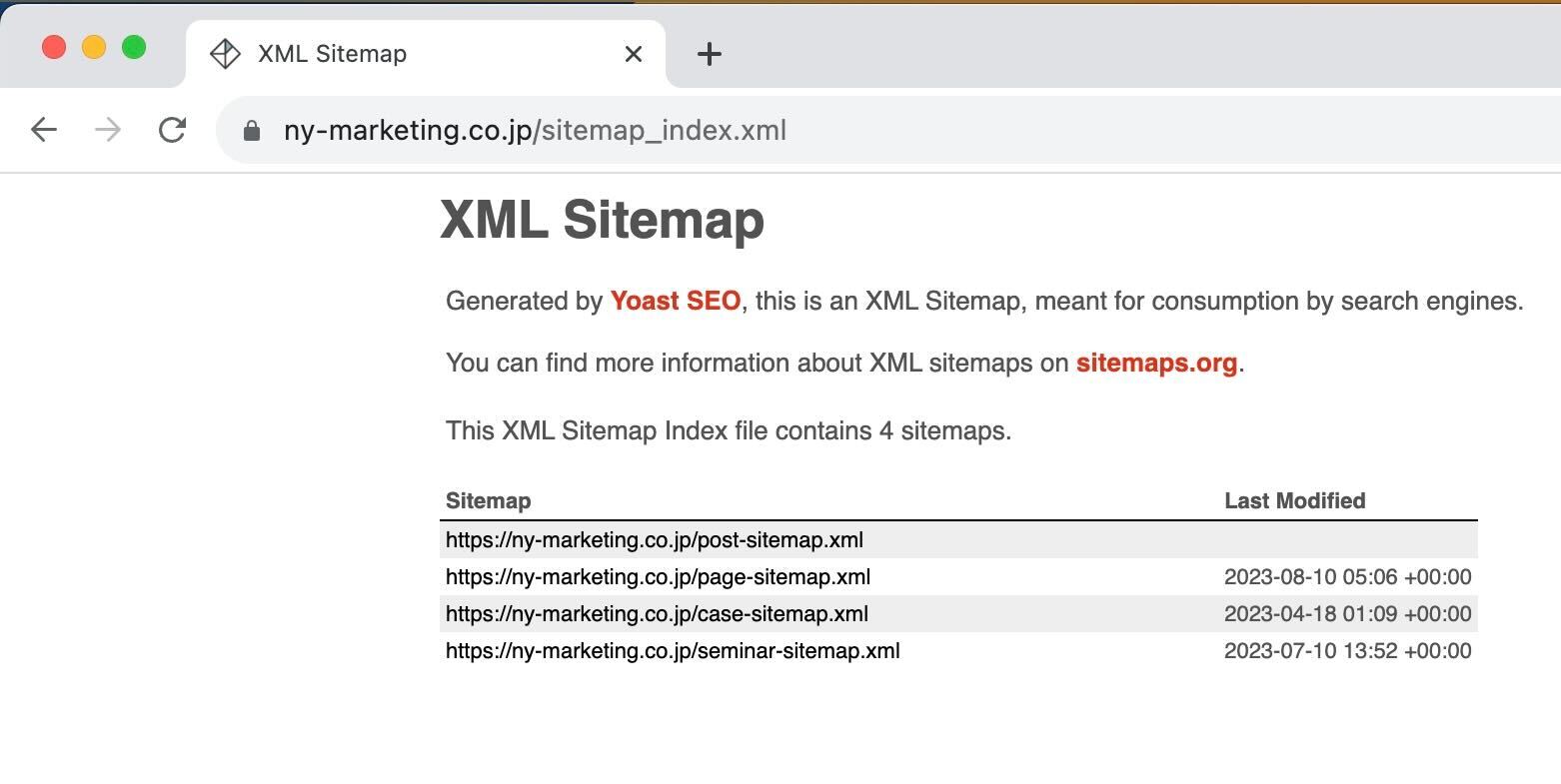

XMLサイトマップについては、サイトURLの末尾に/sitemap.xmlと入力することで確認できるケースが多いです。(※ただし、XMLサイトマップのURLは任意に設定できるため、サイトによってURLが異なります)

上記のキャプチャ画像では、XMLサイトマップの情報と、複数に分割されたXMLサイトマップの一覧が記載されています。上記の例のように、XMLサイトマップは複数に分割して記載することもできます。

robots.txtの役割は大きく3つ

robots.txtの役割は大きく以下の3つに分けられます。

- クローラーの種類を指定・制御する

- クローラーの動きを制御する

- サイトマップの存在を知らせる

それぞれについて解説していきます。

クローラーの種類を指定・制御する

robots.txtでは、User-agent: [クローラー名]という形で、どのクローラーに対して指示を出すかを制御できます。

例えば、User-agent: Googlebotと記述することで、Googleのクローラーだけに指示を出すことができます。

クローラーの動きを制御する

クローラーの動きを制御するためには、Disallow: [制限するパス]という形で記述します。

例えば、Disallow: /wp-admin/と記述すると、/wp-admin/ディレクトリ以下はクロールされません。管理者ページなどに対して使用することが多いです。

XMLサイトマップの存在を知らせる

前述した通り、robots.txtにXMLサイトマップの場所を記述することで、クローラーにその存在を効率的に知らせることができます。

その他、robots.txtの書き方や設定方法についての詳しい説明は、Google公式のドキュメントをご確認ください。

参考:robots.txt の書き方、設定と送信|Google検索セントラル

XMLサイトマップ(sitemap.xml)の役割と効果とは?

XMLサイトマップ(sitemap.xml)はクローラーにWebサイトの情報を効率的に伝える役割があります。詳しく解説します。

サイト上のページ情報をクローラーに伝える役割がある

XMLサイトマップには、Webサイト内の各ページの情報をクローラーに効率的に伝える役割があります。

これにより、新規ページや更新されたコンテンツが速やかに検索エンジンにインデックスされる可能性が高まります。

特に大規模なWebサイトや複雑な構造を持つサイトでは、XMLサイトマップの存在がクローラーによるスムーズなページ認識を促進します。

ページを素早くクロールしてくれる効果がある

XMLサイトマップを使用すると、クローラーがWebサイトをより迅速にクロールすることができます。

これは、「クロール→インデックス→ランキング」というSEOのプロセスにおいて、インデックスまでの時間を短縮し、結果的にSEO評価を向上させる可能性があります。

また、ページ数が多いポータルサイトやECサイトでは、クロールバジェット対策としても有効です。クロールバジェット対策については以下の記事を参考にしてください。

【大規模サイト向け】サイズとURLの上限を超える場合のXMLサイトマップ(sitemap.xml)の作成方法

大規模なWebサイトを運営する場合、XMLサイトマップのサイズやURLの上限に注意を払う必要があります。

XMLサイトマップの各ファイルのURL上限は50,000件、ファイルサイズは圧縮していない場合50MBまでです。

このような状況では、以下の二つの対策方法があります。

- XMLサイトマップを複数に分割する

- XMLサイトマップインデックスファイルを作成する

XMLサイトマップを複数に分割する

XMLサイトマップを2つに分割する場合は、robots.txtに2つ分のXMLサイトマップを記述します。

例えば、以下のように記述します。

User-agent: *

Sitemap: http://www.example.com/sitemap.xml

Sitemap: http://www.example.com/second/sitemap.xml

実際には、カテゴリごとや、アルファベット順、更新日時などの基準に従って、サイトマップを分割することになるでしょう。

サイトマップインデックスファイルを作成する

上記で作成した複数のXMLサイトマップを効率よく管理・認識させるためには、これらをまとめるサイトマップインデックスファイルが必要です。

サイトマップインデックスファイルは、すべての分割されたサイトマップのURLをリストにしたXMLファイルです。

例えば、以下のようにサイトマップインデックスファイルを作成します。

<?xml version="1.0" encoding="UTF-8"?>

<sitemapindex xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<sitemap>

<loc>http://www.example.com/sitemap1.xml</loc>

</sitemap>

<sitemap>

<loc>http://www.example.com/sitemap2.xml</loc>

</sitemap>

</sitemapindex>【補足】大規模サイトのURL管理はSEOツールの利用がおすすめ

大規模サイトではURL管理が煩雑になってしまいがちです。

そのため、大規模サイトの情報を抽出できるSEOツール、例えばbotifyの利用がおすすめです。

botifyは、サイト内で必要なURLのみに絞ってXMLサイトマップをエクスポートすることができます。これにより、効率的にXMLサイトマップを作成し、管理することができます。

もし、botify導入に興味がある場合は、販売パートナーである弊社NYマーケティング株式会社までお問い合わせください。(NYマーケティングのSEOコンサルとbotifyのセット販売となります)

robots.txtとXMLサイトマップ(sitemap.xml)についてよくある質問

robots.txtとXMLサイトマップ(sitemap.xml)に関して、よくある質問にお答えします。

robots.txtにXMLサイトマップ(sitemap.xml)を複数記載してもよい?

複数のXMLサイトマップをrobots.txtに記載することは問題ありません。ただし、小規模なサイトであれば、サイトマップをあえて分ける必要は特にありません。

robots.txtにXMLサイトマップ(sitemap.xml)は必ず書かないといけない?

必須ではありません。robots.txtにXMLサイトマップを記載しない場合は、Google Search ConsoleでXMLサイトマップを直接登録しましょう。

まとめ:robots.txtとXMLサイトマップ(sitemap.xml)の関係性を正しく理解しよう

robots.txtとXMLサイトマップの正確な理解は、サイトが適切にクロールされるために非常に重要です。

クロールされなければ、その先のインデックスやランキングにも影響が出ます。ただし、クローラーの動きを理解して施策として実行するためには、SEOの専門的な知識が必要になります。

弊社NYマーケティングはSEO歴14年のナレッジと実績があります。特に、ECやポータルサイトといった大規模サイトの内部SEOを得意とし、ポータルサイトのPV数を月間1億PVまで伸ばした実績があります。

Googleのクロールに関することのような専門的なSEO対策から、適切な戦略設計・実行まで、私たちにお任せください。初回無料相談を承っております。

また、YouTubeでも専門的なSEO対策の解説も行っています。下記のリンクから動画をチェックしてみてください。

=========

人気のダウンロード資料

【1位】

SEOに強い記事を作るための構成シート

【2位】

SEOチェックシート【全53項目】

【3位】

上位表示させるためのSEO構成作成マニュアル

=========