ポータルサイトのSEOは、記事型とは異なる「DB型(データベース駆動)」の前提を踏まえ、評価をカテゴリ(一覧)ページへ集約する全体設計が勝敗を分けます。本ガイドは、網羅性×新鮮性×内部リンク集約×クローラビリティを軸に、90日で成果を出す実装ロードマップまでを、実務で使える粒度で解説します。

ポータルサイトSEOとは:一般サイトとの違いと「カテゴリ主戦場」戦略の前提

DB型は評価が分散しやすいため、正規化と内部リンクでカテゴリへ評価を集中させることが肝要です。

この章では、カテゴリ(一覧)ページを需要の受け皿とする前提と設計原理を整理します。

ポータルサイトは、検索意図を「エリア×カテゴリ×主要属性」の組合せで満たす設計が基本です。DB型ゆえにURLが増幅しやすく、正規化と内部リンクの集中設計が成果の前提になります。勝ち筋は、需要の受け皿であるカテゴリ(一覧)ページに評価を集約する全体最適であり、網羅性、新鮮性、内部リンク集約(上位・同階層・下位の双方向)、クローラビリティ(不要URLの削減)をテンプレで全ページ標準化します。施策は「クロール最適化→インデックス確実化→ランキング最適化」の順に実装し、0件・重複・無限パラメータを抑え、必要URLの発見性とクロール頻度を最大化することで、一覧を主戦場に据える戦略が回り始めます。

ポータル=DB型サイトの本質:なぜカテゴリーページ(リスト)が勝敗を分けるのか

検索ユーザーが入力する「地域名×カテゴリ名×主要属性」は、結果の一覧を最短で求める意図に直結します。詳細ページは意思決定の最終局面で効きますが、流入の最大口はカテゴリページです。カテゴリは被リンクと内部リンクの集約点として機能し、評価を受け止めて全体を牽引します。さらに、配下アイテムの増減に応じて自動的に更新が走るため、新鮮性シグナルを継続供給できます。SERP理解を助ける構造化データ(ItemList)の適用により、検索結果上での理解とクリック率向上も期待できます(対象ジャンルは限定的ですが、適合する領域では顕著に効きます)。要するに、カテゴリは「需要との合流地点」であり、ここを強くすることが最短の勝利条件です。

ページタイプの四層構造(トップ/カテゴリページ/詳細/補助コンテンツ)と役割分担

トップ→カテゴリ(一覧)→詳細の三層導線で、評価と回遊を循環させます。補助コンテンツ(特集/FAQ/比較/タグ)は差別化が明確なもののみindexし、その他はnoindexで評価の漏れを防ぎます。詳細ページは固有情報・レビュー・代替導線を整え、離脱を防ぎつつカテゴリに評価を返します。人気・新着・関連などの横断導線はテンプレ化し、全ページに実装して内部循環を標準化します。四層が一体で回ると、カテゴリの表示機会が増え、詳細のCVRが伸び、補助が集客と差別化を担う好循環が成立します。

評価軸の再定義:網羅性×新鮮性×内部リンク集約×クローラビリティ

一覧で勝つには、在庫件数の拡充と0件率の抑制による網羅性、募集状態や価格・空室などの反映とlastmodの適正更新による新鮮性、上位・同階層・下位の双方向導線でアンカーを意図に合わせる内部リンク集約、そして不要URL比を継続削減して重要URLのクロール頻度を維持するクローラビリティが不可欠です。社内では一覧スコア(件数・独自テキスト・内部リンク密度・CTR)で可視化し、投資優先度を定量管理します。これらをテンプレに落とし込み、全カテゴリで標準化することが上位の再現性を生みます。

カテゴリーページを強くする全体設計

カテゴリをハブに据え、配下詳細→内部リンク集約→掲載数拡充の循環を設計します。

ここでは、需要意図の可視化と在庫・レビュー・ファセット露出でCTRと満足度を両立させる方法を示します。

カテゴリは「評価を受け止める器」です。配下詳細の固有情報を充実させてカテゴリに評価を返し、一覧のCTRを引き上げるとクロールが増え、掲載拡充の弾みがつきます。この循環をモデル化し、一覧スコアで優先投入を管理します。H1と導入で「エリア×カテゴリ×主要属性」を明示し、主要ファセットと在庫件数・平均評価を上部に可視化します。ItemListとパンくずを実装し、人気・新着・関連の横断モジュールを標準搭載します。業界特性によって「強いカテゴリ」の要件は異なるため、旅行・求人・不動産の差分をテンプレ別に定義しておくと、運用の再現性が飛躍的に高まります。

配下詳細の品質→内部リンク集約→掲載数拡充の評価循環モデル

まず詳細ページで固有情報を厚くし、レビューや代替提案、地域・属性の近傍導線を整えてカテゴリへ評価を返送します。カテゴリのCTRが改善すると、Googlebotの再訪が増え、サイトマップ到達率も上がります。これが掲載拡充の投資対効果を押し上げる駆動力になります。社内では一覧スコア(件数、独自テキスト量、内部リンク密度、CTR)をダッシュボードで見える化し、スコアが一定閾値未満の集合は統合またはnoindexとし、勝ち集合に集中的に投資します。こうした「評価循環」を意図的に作ると、雪だるま式にカテゴリが強くなります。

カテゴリページの必須要素:需要意図の明示、ファセット露出、在庫数・口コミ

カテゴリのH1と導入で「エリア×カテゴリ×主要属性」を明確にし、SERPのクエリとPLP(一覧)を一致させます。主要ファセットは代表のみ固定URLとし、複合や末端はパラメータで制御します。上部に在庫件数と平均評価を可視化し、実利用者のレビューをスニペットで提示するとCTRが伸びます。ItemListとパンくず(BreadcrumbList)を実装し、人気・新着・関連の横断モジュールを標準装備することで、ユーザーの迷いを減らし回遊を増加させます。文面はテンプレで運用しつつ、地域や季節のトピックを差し込むと新鮮性にも効きます。

業界別に異なる「強いカテゴリ」の要件(旅行/求人/不動産の設計差分)

旅行は地理粒度(都道府県/市区/駅/エリア名)と季節性が要で、ホテルや観光在庫とイベント・価格の連動が新鮮性を押し上げます。求人は職種×勤務地×雇用形態が核心で、掲載期限や再掲載の寿命管理をJobPostingスキーマと整合させます。不動産はエリア階層×物件種別×設備ファセットが軸で、満室・成約時の即時処理と画像最適化がUXとSEOの両立に効きます。いずれもカテゴリ冒頭で重要指標(在庫数、平均評価、主要条件)を提示し、PLP一致を高めることが共通の勝ちパターンです。

クロール・インデックス最適化ロードマップ(第1優先)

最初に不要クロールを削り、重要URLの発見性とクロール頻度を引き上げます。

サイトマップ分割と内部リンク改修を同時実装し、GSCと生ログで再クロールを確認します。

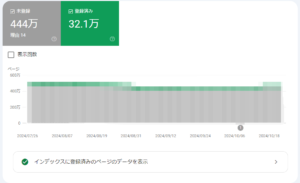

私たちの支援現場では、「検出-未登録」の減少、有効ページの増加、サイトマップ到達率の改善を第一KPIに据えます。NYマーケティングでは生ログ分析ツールを提供しており、不要パラメータや0件・静的資産への過剰クロールを特定して、robots.txt・内部リンク・サイトマップを同時に是正します。修正後は生ログ分析ツールで重要URLへのクロール頻度上昇を確認し、到達率が弱い集合に内部リンクを追加して底上げします。

重複/薄いページの検出:GSCカバレッジ×サーバーログ

GSCのカバレッジでは、有効・除外の推移と「検出-インデックス未登録」を監視し、意図的noindexの比率を健全に保ちます。同時にサーバーログでGooglebotの重要URLクロール頻度や、不要パラメータ・0件・静的資産への過剰比率を可視化します。月次で「必要:不要クロール比」を改善し、残存経路を深掘りして是正します。ログ分析は工数が大きいため、自社ツールでの自動抽出とダッシュボード化が効率的です。これにより、クロールバジェットをカテゴリへ安定的に集中できます。

URL正規化とパラメータ整理:ソート/ページネーション/属性パラメータの方針

パラメータは順序正規化と許可リスト化で生成を制御し、同内容は代表URLへ統合します。ページネーションは自己カノニカルを基本とし、余計なパラメータ引き継ぎを抑えます。ソート、表示切替、サイズ変更などはnoindex+canonicalで代表へ寄せ、ランキング評価の分散を防ぎます。正規化の運用ルールは開発と運用の共有ドキュメントに組み込み、リリース審査でチェックすることで、長期的な健全性を確保します。

canonical/noindex/robots.txtの使い分け基準と適用順序

まず入口である内部リンクを是正してから、robots.txtで大量の不要領域を遮断し、最後にmetaとcanonicalで整合させます。重複の正規化はcanonical、インデックス価値に合わない集合や内部検索はnoindex、パラメータ無限生成系はrobots.txtで遮断するのが原則です。リンク→robots.txt→noindexの「三層防御」で抜け道を塞ぎ、評価の集中を守ります。適用順序を誤ると、発見が止まり回復に時間がかかるため、テスト→段階適用→ログ検証を徹底します。

robots.txtとクローラビリティ:重要領域の保全と無限URLの遮断

内部検索、フィルタ組合せ、セッションID系はrobots.txtでDisallowしつつ、インデックスをさせるページの発見性を阻害しない粒度で記述します。変更後はSearch Consoleのテスターとサーバーログで効果を検証し、重要URLのクロール頻度が上がっているかを確認します。robots.txtで遮断するだけではなく、内部リンク導線の是正とセットで運用し、カテゴリ群へのクローラビリティを常に担保します。

XMLサイトマップ分割(エリア別/カテゴリ別/新着用)と優先度・更新頻度の設計

サイトマップは種別やエリアで分割し、更新頻度の高い集合はlastmodを高頻度で反映します。送信URL数とインデックス数の到達率を週次でモニタリングし、弱い集合には内部リンクの補強や再送を行います。新着用サイトマップを持つと、在庫変化の速いドメインで再クロールが促進されます。

送信運用チェックリスト:lastmod/到達率/検出-未登録の改善サイクル

lastmodは実データに連動させ、差分更新を自動化します。サイトマップ到達率の低い集合は、内部リンクの増強とサイトマップ再送で補強します。「検出-未登録」は発見不足・品質に原因を切り分け、適切な是正を継続します。週次の軽量点検と月次の深掘りで、安定的に到達率を引き上げます。

Search Consoleで見るKPI:有効/除外推移・検出未登録・サイトマップ到達率・クロール統計

有効ページの増加と除外の健全化(意図的noindex比率の安定)がまず重要です。サイトマップ到達率と重要URLのクロール頻度、CTR推移を同一ダッシュボードに統合し、閾値割れの集合にリソースを優先配分します。順位とCTR、クロール頻度の相関を視覚化すると、どこに施策を投下すべきかが即断できます。

情報設計(エリア×カテゴリ×属性)と内部リンクで評価を集約する

URLは「/area/cat/attr/」の固定順で浅い階層に整えます。

パンくず・カテゴリナビ・横断導線で上位・同階層・下位の循環を明確化します。

情報設計は、地理粒度×カテゴリ×属性をMECEに定義し、代表URLへ統合することが要諦です。パンくずはユーザー経路をベースに設計し、BreadcrumbListのJSON-LDで補強します。同カテゴリ内の近傍・類似属性は、質重視で厳選した関連リンクをテンプレ化します。特集・FAQ・コラムなど認知コンテンツからは、意図の明確なアンカーでカテゴリへ評価を返送し、人気・新着の横断枠で再訪・再クロールを促進します。

マスター設計の原則:地理粒度(都道府県/市区/駅)×カテゴリ×属性の階層ルール

地理粒度は検索需要に合わせて定義し、駅/市区/都道府県など粒度の過不足を検証します。属性は代表のみスラッグ化し、細分はパラメータで制御することでURL増幅を抑えます。これにより、代表URLの評価が分散せず、カテゴリ主戦場の整流化が実現します。運用では、粒度の昇格・降格基準をドキュメント化し、需要変化に応じて柔軟に再編できる体制を保ちます。

ディレクトリ/スラッグ命名ガイド:一意性・可読性・将来拡張性

英小文字+ハイフンで統一し、末尾スラッシュや大文字小文字の扱いを全体で揃えます。命名規則と順序正規化は運用ドキュメントに落とし込み、リリース審査に組み込むと実装の揺れを防げます。将来の属性追加にも耐えるスキーマを採ることで、カテゴリの資産価値を長期に保てます。

パンくず・カテゴリナビの最適化:上位/同階層/下位への双方向導線

パンくずは実際のユーザー経路をベースとし、BreadcrumbListをJSON-LDで実装します。カテゴリナビでは、同階層や近傍属性へのリンクを限定し、リンク先のPLP一致とテキストアンカーの整合を重視します。導線の質を担保することが、クロールの最短経路にも直結します。

特集/コラム/FAQからカテゴリページへ評価を循環させる内部リンク網

認知フェーズのコンテンツは、必ずカテゴリ着地への内部リンクで締め、アンカーテキストで意図を明示します。人気・新着の横断枠をテンプレ化し、更新フックを作ることで、再訪・再クロールが継続的に生まれます。結果として、カテゴリのCTRと滞在が伸び、詳細のCVR改善にも波及します。

内部リンクKPI:クロール頻度・PLP一致・検索順位

重要URLの月間クロール頻度、一覧のPLP一致率、カテゴリ群の平均順位を主要KPIとして追います。内部リンクのクリック実績を計測し、送客効率の高いパターンをテンプレへ横展開します。ダッシュボードに統合すると、勝ち導線の再現性が上がり、施策のROIが明確になります。

ファセット・サイト内検索・タグのインデックス制御基準

代表条件のみindexし、複合や末端はnoindex+canonicalで代表に寄せます。

内部検索は原則noindex、常時需要は専用LP化してindexします。

ファセットは「ユニーク需要×在庫件数」が閾値を超える条件のみindex対象とし、それ以外はnoindex+canonicalで代表URLへ統合します。サイト内検索の結果ページは原則noindexですが、常時需要がある上位クエリは編集・固定化したLPとしてindex化します。タグは発行基準と命名・階層ルールを明文化し、乱立を抑制して評価の分散を防ぎます。

ファセット(絞り込み)方針:ユニーク需要×在庫件数が閾値超のみindex、他はnoindex+canonical

0件の条件は生成・露出しないのが基本です。複合条件は代表URLへ寄せ、ページネーションは自己カノニカルでparamの引き継ぎを最小化します。需要の一時的な上昇は昇格基準を満たした時点でindexへ移し、下落時には降格・統合します。これにより、クロールの集中とランキング評価の一極化が実現します。

需要閾値の設計:検索量/コンバージョン/在庫でスコアリング

月間検索量×CVR×在庫件数で代表条件を機械的に選定します。閾値未満はnoindexとし、到達率とCTRの改善によって昇格・降格を運用します。指標はダッシュボードで自動更新し、手動判断を極力減らすと運用負荷が下がり、意思決定の速度が上がります。

サイト内検索結果ページ:原則noindex、常時需要は専用LP化してindex

上位クエリは固定化・編集し、構造化データと内部リンクを整えたLPとしてランディング化します。並び替えや表示切替はnoindex+robotsでクロールを最小化しつつ、カテゴリへの導線を確保します。これにより、内部検索経由の評価漏れを防ぎ、カテゴリ主戦場へ評価を回収できます。

タグページ:乱立抑制(発行基準/命名/階層)と価値基準を明文化

タグは「独自の切り口や比較軸」を満たす編集価値のあるものだけindexします。その他はnoindexで、タグからカテゴリへの評価返送を前提に導線とアンカーを設計します。命名・階層・発行基準を明文化し、運用のぶれと評価の分散を抑制します。

構造化データとリッチリザルト最適化

一覧はItemList、詳細はJobPosting/Reviewなど適切なタイプを選定します。

GSCのリッチリザルトレポートはエラー/警告ゼロを目標に運用します。

公開前の検証と、lastmod・在庫/状態の整合更新を徹底します。構造化の更新は在庫システムと連動し、priceやavailabilityなどを即時反映します。カテゴリにItemList、パンくずにBreadcrumbList、レビューは集計値を正確に記述することで、SERP理解とCTRの改善が見込めます。

カテゴリページにItemList

ListItemのpositionとurlを正確に出力し、0件の一覧では構造化を出さない運用が安全です。これにより、カテゴリのSERPでの見え方が安定し、CTRの底上げに繋がります。

詳細ページのスキーマ選定:JobPosting

JobPosting実装でhiringOrganization、validThrough、勤務地の正確管理が最重要で、募集終了時は状態更新を伴って構造化も即時に変更します。いずれもリッチリザルトの整合性がCTRとCVRに直結します。

レビューUGC:Review

ポータルサイトでは、ユーザー評価を検索結果で可視化するために「Review」構造化マークアップを用います。各店舗や施設のレビュー情報(評価点・コメント・レビュアー名など)をJSON-LD形式でマークアップすることで、Googleが正確に内容を理解し、リッチリザルト(★評価表示)として表示されやすくなります。信頼性向上とCTR改善に効果的です。

UGC(口コミ・Q&A)戦略:品質を上げてCTRとCVRを伸ばす

品質基準は「具体性・検証可能性・時点明記・偏り是正」です。

投稿者属性×内容充足×証拠性でクオリティスコアを作り、露出制御します。

YMYL領域では専門家監修・資格表記・外部エビデンスの連携を必須化します。古い情報は露出を自動低下させ、複数視点を並列表示してバイアスを抑制します。認証済みや購入証跡、継続貢献などで投稿者に重み付けし、表示順位へ反映します。

品質基準の定義:具体性/検証可能性/時点明記/偏り是正

体験事実と根拠を求め、時点(訪問日・購入日)を必須化します。古い情報は自動で露出を下げ、更新や追記で復権できる仕組みにします。賛否や価格・満足・用途など多面的な観点を並列表示し、ユーザーが自分に合う判断軸で選べるようにすると、離脱が減りCVRも改善します。

UGCクオリティスコア(投稿者属性×内容充足×証拠性)

認証済みや購入・利用の証跡、継続的な貢献度で投稿者の信頼をスコアリングします。内容は具体性や比較軸、写真・動画などの証拠性を加点し、表示順位に反映します。低スコアは保留審査や限定露出で品質を維持し、スコア改善のガイダンスを提示して投稿者体験も高めます。

YMYL領域の追加配慮:専門家監修・資格表記・外部エビデンス連携

医療・金融・法律などYMYL領域では、監修者プロフィールと資格を明示し、公式ソースへの出典リンクを徹底します。更新履歴と監修日を明記して時点の信頼性を担保し、UGCは専門家レビューのもとで露出制御を行うことで、検索とユーザー双方の安心感を高めます。

在庫切れ/募集終了/売止めの最適処理

恒久終了は近しいカテゴリや後継へ301、再入荷見込みはページを残し代替提案が原則です。

構造化の状態を即時同期し、季節需要や再掲載可能性でindex維持/削除を分岐します。

在庫・募集の終了は評価資産の保全が最優先です。被リンクと流入、代替有無で301かページを残すかを判定し、ページ残し時は関連記事・人気・類似の導線でユーザー価値を担保します。季節需要の高い集合は次季までページを残し、情報を継続更新します。流入と在庫スコアが閾値下回り続ける集合は、統合やnoindexで評価の分散を抑えます。

恒久終了は301で近しいカテゴリへ、再入荷見込みはページを残し代替提案

恒久終了では被リンク・流入・代替在庫の有無で意思決定し、近しいカテゴリや後継商品へ301します。再入荷見込みがある場合はページを残し、代替提案や人気・関連導線を強化して離脱を防ぎます。構造化マークアップの在庫情報(ホテルなど)、求人掲載ステータスは即時同期し、SERP上の誤情報を防止します。

季節需要・再掲載を踏まえたインデックス維持/削除の分岐

季節性が高い集合は、次季の需要に備えてページを残し、価格や在庫・イベント情報を更新して新鮮性を維持します。低流入が継続し掲載数スコアも閾値を下回る集合は統合またはnoindexで評価を集中させます。運用基準をダッシュボードに組み込み、機械的に判定できる状態を目指します。

業界別の着眼点(求人/旅行/不動産)

求人は掲載期限・法規遵守とJobPosting整合、旅行は地理粒度と季節・在庫連携、不動産は設備ファセットと画像最適化・成約処理が要です。

ここではカテゴリ主戦場に効く差分設計を示します。

業界差分はテンプレに組み込み、オペレーションで迷わないことが重要です。求人はvalidThroughと条件の正確性、終了時の状態更新が命。旅行は価格・空室・イベント連動の新鮮性、エリア設計で深層を浅く回遊可能に。不動産は主要設備の代表ファセット化、成約時の即時処理、画像圧縮とWebPなどでUX/SEOを両立します。

求人:有効期限・法規・JobPostingスキーマと再掲載戦略

求人はvalidThroughと雇用条件の整合が最優先です。終了時は状態更新と場合によりnoindexで誤誘導を防ぎます。再掲載は新鮮性を担保しつつ、旧ページの評価を活かす統合ポリシーを用意し、重複を避けます。カテゴリでは職種×勤務地×雇用形態を上部に可視化し、PLP一致とCTRを高めます。

旅行:地理粒度/季節性/在庫連携(Hotel)と特集の役割

旅行では地理粒度の適正化がCTRに直結します。シーズン特集はカテゴリへの内部リンクで評価を返送し、価格・空室・イベント連動で新鮮性を維持します。エリア内部リンクは周辺の近傍カテゴリへ短経路で到達できるよう設計し、深層ページでも迷わない導線を確保します。

不動産:エリア階層/設備ファセット/掲載終了処理と画像最適化

主要設備は代表ファセットとして露出し、末端条件はnoindexで評価集中を図ります。満室・成約時は代替提案を上部に表示し、画像は圧縮とWebPで読み込みを軽量化します。カテゴリには在庫件数、平均賃料や評価を明示し、意思決定を早める設計が有効です。

外部・コンテンツ施策の役割分担(カテゴリページに評価を集約)

メディア記事は認知と被リンク獲得の器として企画し、内部リンクでカテゴリへ還流します。

外部評価は独自データ・調査・アワードで取りに行きます。

PRとSEOを分離せず、企画段階から「リンクされる理由」を設計します。一次データ公開や地域・業界のアワード企画は、高信頼ドメインからの被リンク獲得に有効で、カテゴリ主戦場への評価集中に直結します。記事テンプレには、カテゴリ導線の位置・文言をABテストで最適化する項目を標準装備します。

メディア記事は認知施策:内部リンクでカテゴリページへ評価還流

比較・調査・事例の編集企画で話題を作り、本文中の適切な位置に意図の明確なアンカーでカテゴリへの導線を固定します。記事テンプレには導線の固定位置と文言のバリエーションを持ち、ABで最適化します。これにより、露出が伸びるほどカテゴリが強くなる構造ができます。

被リンク獲得:独自データ/調査レポート/アワード・ランキング企画

一次データの公開や地域・業界アワードは、自然なリンク獲得の確率を高めます。自治体や業界団体と連携し、掲載側の便益(引用しやすいデータ形式、ロゴ・バッジ提供)を設計しておくことが重要です。受け皿はカテゴリで、関連する特集からも評価が還流するよう内部リンクを設計します。

KPI再定義とダッシュボード設計

「カテゴリ別オーガニックUU×CVR×収益」に直結する指標へKPIを再設計します。テクニカルでは、クロール→インデックス→ランディングを一気通貫で監視します。

ビジネスKPI:カテゴリ別オーガニックUU×CVR×収益貢献で評価

カテゴリ別のUU数、CVR、収益寄与を主要KPIとしてモニタリングします。アシスト(特集・FAQ)からカテゴリへの送客効率も並行評価し、記事テンプレと内部リンクのABで継続的に最適化します。これにより、流入と収益の直結度が上がります。

テクニカルKPI:クロール→インデックス→ランディングの監視

被クロール率(重要URL/総クロール)、検出-未登録、サイトマップ到達率を核に、重要URLのクロール頻度×順位×CTRの相関を可視化します。相関が高い集合から順に施策を投入し、限られた工数で最大の改善を狙います。

プロダクトKPI:在庫数/新着率/レビュー獲得速度とSEOの相関

在庫拡充や新着投入がCTRや順位に与える影響をダッシュボードで追跡し、投入スピードのKPIを決めます。レビュー増加とCVRの弾性値を追い、レビュー施策のROIを明らかにします。これにより、プロダクトとSEOの連携が日次で回り始めます。

90日実装ロードマップ(優先順位つき)

フェーズ1は正規化・robots.txt制御で無駄なクロールを削り、フェーズ2でサイトマップ分割とカテゴリ必須要素を実装します。

フェーズ3でファセット・内部検索/タグ・構造化を本番適用、フェーズ4で内部リンク網とKPI運用を定着させます。

NYマーケティングの支援では、各フェーズの完了ごとにサーバーログで再クロールを確認し、サイトマップ到達率と「検出-未登録」の改善をKPIに次工程へ進みます。以下を90日で回すと、カテゴリ主戦場の基盤が完成します。

Day1-14:URL正規化、noindex/canonical決定、robots.txt調整

パラメータ許可リストと順序正規化、自己カノニカルの徹底を最初に行います。内部検索や無限生成系はrobotsで遮断し、noindexの適用範囲を整理します。ここでの決定が以後の評価集中を左右するため、リリース審査のチェックリスト化が有効です。

Day15-30:XMLサイトマップ分割と送信、カテゴリページの必須要素整備

種別/エリア別サイトマップを作成し、lastmodをデータ連動させます。カテゴリにはItemList、在庫件数、主要レビュー、人気・新着導線を実装します。到達率を監視し、弱い集合は内部リンクで補強します。

Day31-60:ファセット基準導入、サイト内検索/タグ方針、構造化データ実装

代表条件のみindex、その他はnoindex+canonicalへ移行します。内部検索は原則noindex、常時需要は専用LP化します。JobPosting/Reviewを要件に応じて適用し、GSCのリッチリザルトレポートでエラーゼロ運用を開始します。

Day61-90:パンくず/内部リンク網の再設計、KPIダッシュボード運用開始

トップ→一覧→詳細の双方向導線を再設計し、孤立を排除します。GSC/ログ/サイトマップ/順位/CTRを統合可視化し、月次の運用へ移行します。以後は一覧スコアと必要:不要クロール比の改善を継続します。

まとめ|今日から始める「カテゴリ主戦場」SEOと実装支援のご案内

最短で成果を出すには、「クロール最適化→インデックス確実化→カテゴリ評価集約」を順守します。

情報設計・テンプレ実装・内部リンク・構造化・サイトマップを全体最適で連動させます。

0件・重複・無限URLを抑え、代表ページを強化することが雪だるま式成長の起点です。NYマーケティングは、生ログ解析×サイトマップ×内部リンクの三位一体で伴走し、10万ページ超のDB型で蓄積した知見をテンプレに落とし込みます。まずは90日で基盤を作り、その後は月次でスコアの閾値運用を回すことで、カテゴリ主戦場の優位を固めましょう。

※上記90日プランはサンプルです。費用に応じて改善スピードは異なります。

最重要は全体最適:カテゴリページを軸にクロール・インデックス・内部リンクを連動させる

三層導線と代表URLの正規化で評価を集中させ、テンプレの横展開で全体の底上げを図ります。KPIダッシュボードで「検出→クロール→インデックス→ランキング→収益」を一元管理し、閾値割れに自動で気づける運用を作ることが、持続的な伸長の決め手になります。

当社支援メニュー:クロール改善~サイト設計・整備、コンテンツ戦略まで包括的にコンサルティング

初期はログ解析、robots・サイトマップ設計、正規化運用の是正を行い、次にURL/テンプレ/構造化・ファセット方針/内部リンク網を設計して実装します。特集や調査レポートの企画で被リンクを獲得し、レビュー運用・YMYL監修体制の構築まで包括支援します。KPIダッシュボード導入と90日スプリント運用で成果創出を伴走します。